Maschinelles Lernen (Machine Learning, ML) ist ein Teilbereich der künstlichen Intelligenz, der Computersysteme befähigt, aus Daten zu lernen und ihre Leistung kontinuierlich zu verbessern – ohne explizite Programmierung für jede Aufgabe.

Das Kernprinzip unterscheidet sich fundamental von traditioneller Software: Statt detaillierte Regeln zu programmieren, lernen ML-Algorithmen selbständig aus Beispielen. Ein Spam-Filter wird mit tausenden E-Mails trainiert und erkennt danach eigenständig, welche Merkmale auf Spam hindeuten. Diese Fähigkeit, Muster in großen Datenmengen zu erkennen, macht maschinelles Lernen zur Schlüsseltechnologie für Innovationen in Industrie, Medizin, Finanzwesen und vielen weiteren Bereichen.

Wie funktioniert maschinelles Lernen?

Der iterative Lernprozess

Maschinelles Lernen basiert auf einem iterativen Prozess. Am Anfang steht die Datenerhebung – ein ML-System benötigt Beispieldaten, aus denen es lernen kann. Diese Trainingsdaten können aus Unternehmensdatenbanken, Sensoren in Produktionsanlagen, Transaktionsdaten oder öffentlich zugänglichen Datensätzen stammen.

Nach der Datenerhebung folgt die Aufbereitung. Rohdaten werden bereinigt, strukturiert und in ein geeignetes Format gebracht. Fehlende Werte werden ergänzt, Ausreißer identifiziert und Daten normalisiert. Die Qualität des Modells hängt maßgeblich von der Qualität der Eingabedaten ab.

Im nächsten Schritt beginnt das eigentliche Training. Ein Lernalgorithmus analysiert die vorbereiteten Daten und sucht nach Mustern, Zusammenhängen und Regelmäßigkeiten. Dabei passt der Algorithmus die Parameter eines mathematischen Modells so an, dass es die Trainingsdaten möglichst gut abbildet.

Das trainierte Modell wird anschließend auf neue, bisher unbekannte Daten angewendet. Basierend auf den gelernten Mustern trifft es Vorhersagen, klassifiziert Informationen oder erkennt Anomalien. Die Leistung wird kontinuierlich bewertet, indem die Vorhersagen mit den tatsächlichen Ergebnissen verglichen werden.

Was sind die drei Kernkomponenten des maschinellen Lernens?

Für erfolgreiches maschinelles Lernen müssen drei wesentliche Komponenten zusammenwirken:

- Daten

- Bilden das Fundament jedes ML-Systems

- Können in strukturierter Form vorliegen (z.B. Tabellen) oder unstrukturiert sein (Texte, Bilder, Audiodateien)

- Qualität und Menge bestimmen die Leistungsfähigkeit des Modells

- Algorithmen und Lernverfahren

- Bestimmen, wie das System aus den Daten lernt

- Reichen von einfachen linearen Regressionen bis zu komplexen neuronalen Netzen

- Auswahl hängt von Aufgabenstellung, Datenmenge und Anforderungen ab

- Rechenleistung

- Notwendig für rechenintensive Trainings- und Optimierungsprozesse

- Spezialisierte Hardware wie GPUs beschleunigen die Berechnungen

- Cloud-Computing-Infrastrukturen bieten flexible Skalierbarkeit

Wie unterscheidet sich maschinelles Lernen von traditioneller Programmierung?

Bei traditioneller Software formulieren Entwickler explizite Regeln für jede Situation. Maschinelles Lernen kehrt dieses Prinzip um: Statt Regeln zu programmieren, werden dem System Beispiele gezeigt. Der Algorithmus leitet daraus selbstständig Regeln ab.

Ein Beispiel: Um ein Programm zur Erkennung von Katzen in Bildern zu erstellen, müsste ein traditioneller Ansatz unzählige Regeln definieren – Fellmuster, Ohrform, Schnurrhaare, typische Körperhaltungen. Ein ML-System lernt aus tausenden Beispielbildern von Katzen und Nicht-Katzen, welche visuellen Merkmale charakteristisch sind, ohne dass diese Merkmale explizit beschrieben werden müssen.

Welche Arten des maschinellen Lernens gibt es?

Maschinelles Lernen lässt sich nach der Art des Lernprozesses in drei Hauptkategorien einteilen:

| Art des Lernens | Beschreibung | Typische Anwendungen | Beispiele |

| Überwachtes Lernen (Supervised Learning) | Training mit gelabelten Daten, bei denen die korrekte Antwort bekannt ist | Klassifikation und Regression | Spam-Filter, Bilderkennung, Kreditrisikobewertung, Preisprognosen |

| Unüberwachtes Lernen (Unsupervised Learning) | Mustererkennung in Daten ohne vorgegebene Labels | Clustering, Anomalieerkennung, Dimensionsreduktion | Kundensegmentierung, Empfehlungssysteme |

| Bestärkendes Lernen (Reinforcement Learning) | Lernen durch Interaktion mit der Umgebung und Feedback (Belohnungen/Bestrafungen) | Sequentielle Entscheidungen, Optimierung von Strategien | Robotersteuerung, Spielstrategien |

Wie funktioniert überwachtes Lernen?

Überwachtes Lernen (Supervised Learning) ist die am weitesten verbreitete Form des maschinellen Lernens. Der Algorithmus wird mit gelabelten Trainingsdaten trainiert – jedes Beispiel im Datensatz ist mit der korrekten Antwort versehen.

Das Modell erhält Eingabedaten und die zugehörigen korrekten Ausgaben. Es analysiert die Beziehung zwischen Eingabe und Ausgabe und passt seine Parameter so an, dass es bei neuen, unbekannten Eingaben möglichst genaue Vorhersagen treffen kann.

Klassifikation vs. Regression

Überwachtes Lernen wird hauptsächlich für zwei Arten von Aufgaben eingesetzt:

| Aspekt | Klassifikation | Regression |

| Ausgabetyp | Kategorien/Klassen (diskret) | Numerische Werte (kontinuierlich) |

| Fragestellung | „Zu welcher Kategorie gehört dies?“ | „Welchen Wert wird dies haben?“ |

| Beispiele | Spam vs. kein Spam, Katze vs. Hund, Krankheit ja/nein | Immobilienpreise, Energieverbrauch, Kreditrisiko-Score |

| Typische Algorithmen | Entscheidungsbäume, Support Vector Machines, Neuronale Netze | Lineare Regression, Random Forest, Neuronale Netze |

Bei der Klassifikation ordnet das Modell Eingabedaten vordefinierten Kategorien zu. Ein Spam-Filter klassifiziert E-Mails in „Spam“ oder „kein Spam“, ein Bilderkennungssystem identifiziert Objekte in Fotos, und ein medizinisches Diagnosesystem kategorisiert Röntgenbilder nach Krankheitsmerkmalen.

Bei der Regression sagt das Modell kontinuierliche numerische Werte voraus: die Vorhersage von Immobilienpreisen basierend auf Lage und Ausstattung, die Schätzung des Energieverbrauchs einer Produktionsanlage oder die Kalkulation von Kreditrisiken anhand von Finanzdaten.

Was kennzeichnet unüberwachtes Lernen?

Unüberwachtes Lernen (Unsupervised Learning) arbeitet mit Daten ohne vorgegebene Labels oder Kategorien. Der Algorithmus erhält nur die Eingabedaten und muss selbstständig interessante Strukturen, Muster oder Gruppierungen entdecken.

Die häufigste Anwendung ist das Clustering, bei dem ähnliche Datenpunkte zu Gruppen zusammengefasst werden. Ein Algorithmus könnte beispielsweise Kunden eines Unternehmens anhand ihres Kaufverhaltens automatisch in verschiedene Segmente einteilen, ohne dass vorab definiert wurde, welche Segmente existieren sollten.

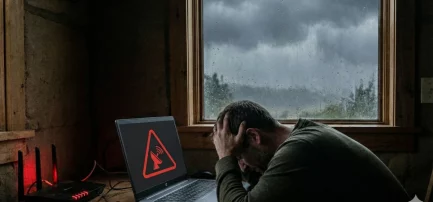

Anomalieerkennung identifiziert ungewöhnliche Muster, die von der Norm abweichen. In der IT-Sicherheit hilft dies dabei, verdächtige Aktivitäten im Netzwerkverkehr zu identifizieren, die auf Cyberangriffe hindeuten könnten.

Worum geht es beim bestärkenden Lernen?

Bestärkendes Lernen (Reinforcement Learning) verfolgt einen anderen Ansatz. Ein Agent – ein autonomes System – lernt durch Interaktion mit seiner Umgebung. Der Agent führt Aktionen aus und erhält dafür Feedback in Form von Belohnungen oder Bestrafungen.

Das Prinzip ähnelt dem Lernen durch Versuch und Irrtum. Aktionen mit positiven Ergebnissen werden verstärkt und in Zukunft häufiger gewählt. Aktionen mit negativen Folgen werden vermieden. Über viele Durchläufe entwickelt das System eine Strategie, die die langfristige Belohnung maximiert.

Bestärkendes Lernen kommt überall dort zum Einsatz, wo Systeme sequentielle Entscheidungen treffen müssen: Roboter in der Fertigung optimieren ihre Bewegungsabläufe. In Spielen haben RL-Algorithmen beeindruckende Erfolge erzielt.

Wie unterscheiden sich KI, maschinelles Lernen, Deep Learning und neuronale Netze?

Die Begriffe werden häufig synonym verwendet, bezeichnen aber unterschiedliche Konzepte in einer hierarchischen Beziehung:

| Begriff | Definition | Verhältnis | Charakteristik |

| Künstliche Intelligenz (KI) | Fähigkeit von Maschinen, Aufgaben auszuführen, die menschliche Intelligenz erfordern | Oberbegriff für alle intelligenten Systeme | Umfasst regelbasierte Systeme und lernfähige Algorithmen |

| Maschinelles Lernen (ML) | Systeme, die aus Daten lernen und ihre Leistung durch Erfahrung verbessern | Teilbereich der KI | Datengetriebener Ansatz ohne explizite Programmierung |

| Neuronale Netze | Algorithmen inspiriert von der Struktur des menschlichen Gehirns | Teilbereich des ML | Verarbeitung in Schichten verbundener künstlicher Neuronen |

| Deep Learning | Neuronale Netze mit vielen Schichten | Teilbereich neuronaler Netze | Automatische Merkmalsextraktion, benötigt große Datenmengen |

In welchen Bereichen wird maschinelles Lernen eingesetzt?

Maschinelles Lernen durchdringt nahezu alle Wirtschaftsbereiche. Die folgende Übersicht zeigt die wichtigsten Anwendungsgebiete:

| Branche | Anwendungsfall | Konkretes Beispiel | Nutzen |

| Industrie & Produktion | Predictive Maintenance | Vorhersage von Maschinenausfällen aus Sensordaten (Vibrationen, Temperatur) | Minimierung von Ausfallzeiten, Kostensenkung |

| Qualitätskontrolle | Bilderkennungssysteme zur Fehlererkennung | Höhere Prüfgeschwindigkeit und -präzision | |

| Produktionsoptimierung | Optimierung von Maschinenparametern | Reduzierung von Ausschuss, Energieeinsparung | |

| Finanzsektor | Betrugserkennung | Echtzeit-Identifikation verdächtiger Transaktionen | Reduktion von Betrugsschäden, Kundenschutz |

| Kreditrisikobewertung | Automatisierte Bonitätsprüfung mit multiplen Faktoren | Differenziertere Risikobewertung | |

| Algorithmisches Trading | Automatisierte Handelsentscheidungen basierend auf Marktdaten | Schnellere Reaktion auf Marktveränderungen | |

| E-Commerce & Marketing | Produktempfehlungen | Personalisierte Vorschläge basierend auf Nutzerverhalten | Höhere Conversion-Rate, Kundenbindung |

| Kundensegmentierung | Automatische Identifikation von Kundengruppen | Präziseres Targeting, effektivere Kampagnen | |

| Churn-Prediction | Vorhersage von Kundenabwanderung | Rechtzeitige Retention-Maßnahmen | |

| Gesundheitswesen | Bildanalyse | Unterstützung bei der Auswertung von Röntgen, CT, MRT | Unterstützung bei Diagnosen |

| Drug Discovery | Vorhersage der Wirksamkeit von Wirkstoffen | Beschleunigung der Medikamentenentwicklung | |

| Personalisierte Medizin | Individuelle Behandlungspläne basierend auf Patientendaten | Individualisierte Therapieansätze | |

| IT-Sicherheit | Malware-Erkennung | Verhaltensbasierte Identifikation von Schadsoftware | Schutz vor neuen Bedrohungen |

| Anomalieerkennung | Identifikation ungewöhnlicher Zugriffsmuster | Früherkennung von Sicherheitsvorfällen | |

| Phishing-Erkennung | Automatische Identifikation betrügerischer E-Mails | Schutz sensibler Unternehmensdaten | |

| Kommunikation | Spracherkennung | Umwandlung von Sprache in Text | Sprachassistenten, automatische Transkription |

| Maschinelle Übersetzung | Automatische Übersetzung zwischen Sprachen | Überwindung von Sprachbarrieren | |

| Natural Language Processing | Chatbots für Kundenservice | Automatisierung von Kundenanfragen, 24/7-Verfügbarkeit |

Welche Voraussetzungen braucht erfolgreiches maschinelles Lernen?

Warum sind Datenqualität und Datenmenge so wichtig?

Die Qualität der Trainingsdaten bestimmt maßgeblich die Leistungsfähigkeit eines ML-Modells. Hochwertige Daten sind vollständig, korrekt, konsistent und relevant für die zu lösende Aufgabe.

Die benötigte Datenmenge variiert je nach Problemstellung. Einfache ML-Modelle können mit wenigen hundert oder tausend Beispielen trainiert werden, während komplexe Deep-Learning-Systeme oft Millionen von Datenpunkten benötigen.

Die Repräsentativität der Daten ist kritisch. Die Trainingsdaten müssen die reale Anwendungssituation abbilden und alle relevanten Fälle umfassen. Bias in den Trainingsdaten führt zu verzerrten Vorhersagen, die bestehende Ungleichheiten verstärken können.

Welche Infrastruktur wird benötigt?

Das Training komplexer Modelle erfordert erhebliche Rechenleistung. Spezialisierte Hardware wie Grafikkarten (GPUs) oder speziell für ML entwickelte Prozessoren (TPUs) beschleunigen die rechenintensiven Operationen um ein Vielfaches.

Unternehmen stehen vor der Wahl zwischen On-Premise-Lösungen mit voller Kontrolle oder cloud-basierten ML-Plattformen wie AWS SageMaker, Google Cloud AI oder Azure Machine Learning, die flexible, skalierbare Ressourcen ohne hohe Anfangsinvestitionen bieten.

Welche Fachkompetenz ist erforderlich?

Data Scientists bringen Kenntnisse in Statistik, Mathematik und Programmierung mit. Sie wählen geeignete Algorithmen aus, bereiten Daten auf, trainieren Modelle und evaluieren deren Leistung.

Machine Learning Engineers fokussieren sich auf die produktive Umsetzung. Sie bauen robuste ML-Pipelines, integrieren Modelle in bestehende Systeme und sorgen für Skalierbarkeit und Performance.

Domänenexpertise ist unverzichtbar. Fachexperten aus dem jeweiligen Anwendungsbereich bringen das notwendige Verständnis mit, um relevante Fragestellungen zu formulieren, Daten richtig zu interpretieren und Ergebnisse zu validieren.

Welche mathematischen Grundlagen sind wichtig?

Statistik bildet das Fundament, da ML-Algorithmen auf statistischen Prinzipien basieren. Konzepte wie Wahrscheinlichkeitsverteilungen und Stichprobentheorie sind zentral.

Lineare Algebra ist unverzichtbar für das Verständnis, wie Daten repräsentiert und transformiert werden. Matrizen und Vektoren sind die grundlegenden Datenstrukturen in ML.

Optimierung beschäftigt sich damit, wie ML-Algorithmen die besten Modellparameter finden. Das Gradientenverfahren und seine Varianten sind zentral für das moderne maschinelle Lernen.

Welche Herausforderungen gibt es beim maschinellen Lernen?

Maschinelles Lernen steht vor bedeutenden Herausforderungen, die von technischen Schwierigkeiten bis zu ethischen Problemen reichen:

1. Overfitting und Underfitting

Overfitting tritt auf, wenn ein Modell zu eng an die Trainingsdaten angepasst ist. Es lernt nicht nur die zugrundeliegenden Muster, sondern auch zufällige Schwankungen auswendig. Das Resultat ist ein Modell, das auf den Trainingsdaten hervorragend funktioniert, bei neuen Daten aber versagt.

Underfitting ist das entgegengesetzte Problem. Ein zu einfaches Modell kann die Komplexität der Daten nicht erfassen und erzielt sowohl auf Trainings- als auch auf Testdaten schlechte Ergebnisse.

Techniken wie Kreuzvalidierung und Regularisierung helfen dabei, die richtige Balance zu finden.

2. Bias in Trainingsdaten

Verzerrungen in den Trainingsdaten führen zu verzerrten Modellen. Wenn wichtige Bevölkerungsgruppen in den Daten unterrepräsentiert sind, wird das Modell für diese Gruppen schlechtere Vorhersagen liefern. Historische Diskriminierungen, die in den Daten enthalten sind, werden vom Modell gelernt und reproduziert.

Beispiele:

- Bewerbungssysteme mit geschlechtsspezifischen Verzerrungen aus historischen Einstellungsdaten

- Gesichtserkennungssysteme mit unterschiedlicher Performance bei verschiedenen Hautfarben

- Kreditscoring-Algorithmen, die sozioökonomische Ungleichheiten verstärken können

3. Rechenintensität und Kosten

Das Training großer ML-Modelle erfordert massive Rechenressourcen. Ein einzelner Trainingslauf für komplexe Sprachmodelle kann mehrere Wochen auf hunderten von GPUs dauern und erhebliche Kosten verursachen.

Die Energiebilanz großer ML-Modelle verbraucht erhebliche Mengen Strom und trägt zum CO2-Ausstoß bei.

Open-Source-Modelle, Transfer Learning und effizientere Algorithmen helfen dabei, diese Kosten zu senken.

4. Erklärbarkeit (Explainability)

Viele moderne ML-Modelle, insbesondere tiefe neuronale Netze, sind „Black Boxes“. Sie liefern Vorhersagen, aber die innere Logik bleibt verborgen.

In regulierten Branchen wie dem Finanzwesen oder der Medizin müssen Entscheidungen nachvollziehbar und überprüfbar sein. Wenn ein ML-System einen Kreditantrag ablehnt oder eine medizinische Diagnose stellt, müssen die Gründe erklärt werden können.

Das Forschungsfeld „Explainable AI“ entwickelt Methoden, um die Entscheidungen von ML-Modellen nachvollziehbar zu machen. Techniken wie LIME oder SHAP können erklären, welche Eingabemerkmale zu einer bestimmten Vorhersage geführt haben.

5. Ethische und rechtliche Fragen

Datenschutz: ML-Systeme benötigen große Datenmengen, die häufig personenbezogene Informationen enthalten. Die Datenschutz-Grundverordnung (DSGVO) stellt strenge Anforderungen an die Verarbeitung solcher Daten.

Haftungsfragen: Wenn eine KI-basierte Entscheidung zu Schäden führt, stellt sich die Frage nach der Verantwortung. Ist der Entwickler des Algorithmus haftbar, der Anbieter des Systems oder der Anwender?

Zertifizierung: Anders als bei traditioneller Software gibt es für ML-Modelle keine Korrektheitsgarantie. Standards und Prüfverfahren für KI-Systeme sind noch in der Entwicklung.

Wie hat sich maschinelles Lernen entwickelt?

Welche Pionierleistungen prägten die Anfänge?

Die konzeptionellen Anfänge reichen bis in die 1940er Jahre. Warren McCulloch und Walter Pitts entwickelten 1943 das erste mathematische Modell eines künstlichen Neurons. Alan Turing stellte 1950 die Frage „Can machines think?“ und entwickelte den Turing-Test als Kriterium für maschinelle Intelligenz.

Frank Rosenblatt entwickelte 1958 das Perceptron, einen der ersten Algorithmen für überwachtes Lernen. Die Maschine „Mark 1 Perceptron“ wurde 1960 gebaut und konnte grundlegende Muster in Bildern erkennen – ein erster Schritt zur modernen Bilderkennung.

Was brachte den Durchbruch?

Mehrere Entwicklungen führten ab den 1980er Jahren zu einer Renaissance des maschinellen Lernens:

Die Wiederentdeckung des Backpropagation-Algorithmus 1986 ermöglichte das Training mehrschichtiger neuronaler Netze. Zuvor unlösbare Probleme wurden plötzlich angehbar.

Die exponentielle Steigerung der Rechenleistung folgte dem Moore’schen Gesetz. Dies machte komplexe Berechnungen möglich, die zuvor undenkbar waren.

Die Entstehung des Internets und die Digitalisierung führten zu einer Datenexplosion. Plötzlich standen riesige Datenmengen zur Verfügung – Bilder, Texte, Nutzerinteraktionen.

Open-Source-Frameworks wie TensorFlow, PyTorch und scikit-learn demokratisierten maschinelles Lernen. Cloud-Computing ermöglichte den Zugang zu massiver Rechenleistung ohne große Investitionen.

Der Durchbruch im Deep Learning kam 2012, als ein neuronales Netz bei der ImageNet-Challenge die Konkurrenz mit deutlichem Vorsprung schlug. Dies markierte den Beginn der modernen Deep-Learning-Ära.

Fazit: Maschinelles Lernen als Katalysator der digitalen Transformation

Maschinelles Lernen hat sich von einer akademischen Disziplin zu einer Schlüsseltechnologie entwickelt, die nahezu alle Wirtschaftsbereiche durchdringt. Die Fähigkeit, aus Daten zu lernen und Muster zu erkennen, eröffnet Möglichkeiten, die mit traditioneller Programmierung undenkbar wären.

Was bedeutet das für Unternehmen?

Für Unternehmen im B2B-Bereich ist maschinelles Lernen eine strategische Notwendigkeit. Der Einstieg sollte mit fokussierten Anwendungen in klar definierten Bereichen beginnen, bei denen ausreichend Daten vorhanden sind, der geschäftliche Nutzen klar ist und die technische Komplexität überschaubar bleibt.

Die Investition in Kompetenzaufbau ist ebenso wichtig wie technologische Infrastruktur. Data Scientists und ML-Engineers sind gefragt, aber auch die Qualifizierung bestehender Teams und die Sensibilisierung des Managements sind erfolgskritisch.

Wohin entwickelt sich maschinelles Lernen?

Die Entwicklung geht in mehrere Richtungen:

- AutoML (automatisiertes maschinelles Lernen) vereinfacht die Erstellung von ML-Modellen und macht die Technologie für Nicht-Experten zugänglicher

- Transfer Learning ermöglicht es, vortrainierte Modelle mit weniger Daten auf spezifische Aufgaben anzupassen

- Federated Learning erlaubt das Training auf verteilten Datenbeständen ohne Zentralisierung sensibler Daten

- Edge ML bringt maschinelles Lernen auf Endgeräte und ermöglicht Echtzeitverarbeitung ohne Cloud-Anbindung

Maschinelles Lernen wird zunehmend zur Basistechnologie, die in immer mehr Anwendungen unsichtbar im Hintergrund arbeitet. Unternehmen, die jetzt einsteigen, eröffnen sich erhebliche Chancen für Innovation und Wettbewerbsvorteile.